AI视频生成领域又迎来一个重磅工具。

日前,AI科学家李飞飞团队与谷歌合作,推出了视频生成模型W.A.L.T(Window Attention Latent Transformer)——一个在共享潜在空间中训练图像和视频生成的、基于Transformer架构的扩散模型。

李飞飞是华裔女科学家、世界顶尖的AI专家,现为美国斯坦福大学终身教授、斯坦福大学人工智能实验室主任,曾任谷歌副总裁和谷歌云首席科学家。前OpenAI研究员、曾担任特斯拉人工智能和自动驾驶视觉总监的Andrej Karpathy便是其得意弟子。

从展示的案例来看,W.A.L.T的效果媲美Gen-2比肩Pika,其可以根据自然语言/图片提示生成逼真的2D/3D视频或动画。

A Teddy bear skating carefully in Times Square,Slow Motion/一只泰迪熊在时代广场上优雅的滑冰,慢动作

An stronaust riding a horse/一名宇航员骑着马

A giant dragon sitting in a snow covered landscape, breathing fire/一条巨大的龙盘踞在冰雪覆盖的大地上,喷吐着火焰

Cameraturns around a cute bunny, studio lighting, 360 rotation/相机围绕一只可爱的兔子旋转,工作室灯光,360度旋转

评论区有不少人惊叹,“好莱坞的末日!”“跨域式的发展!”还有人提问,“能嵌入消费电子产品上吗?代码会开源吗?”

相关论文已经发布(见下图)。

怎么做到的?

核心研究人员阿格里姆古普塔(Agrim Gupta)代表李飞飞团队对W.A.L.T的两个关键决策作了详细介绍:

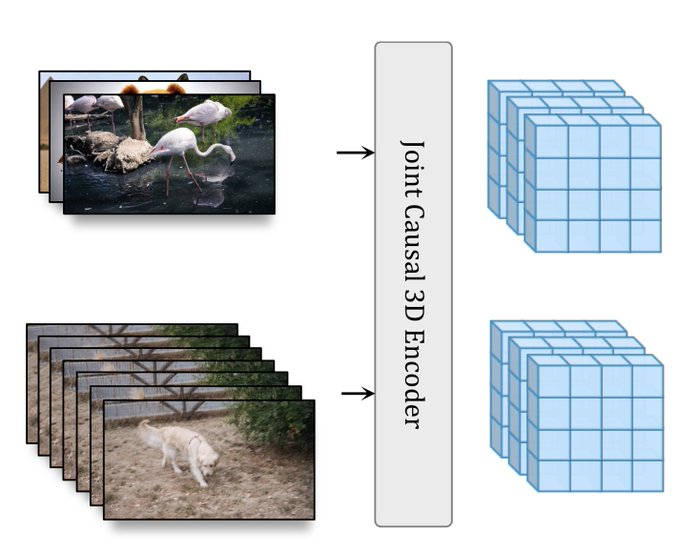

首先,研究者使用因果编码器(causal encoder)在统一的潜在空间内联合压缩图像和视频,从而实现跨模态的训练和生成。

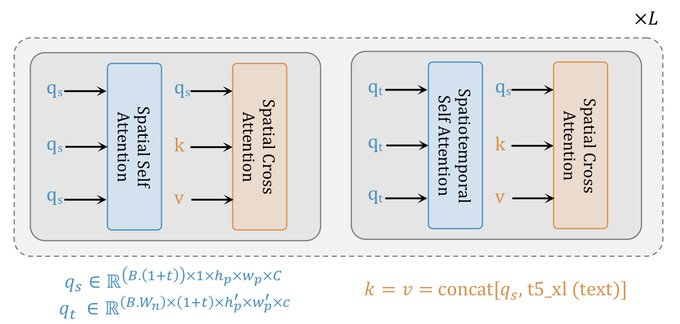

其次,为了提高记忆和训练效率,研究者使用了为空间和时空联合生成建模量身定制的窗口注意力机制(window attention),注:该机制基于transformer架构。

通过这两个关键决策,团队在已建立的视频(UCF-101和Kinetics-600)和图像(ImageNet)生成基准测试上实现了SOTA,而无需使用无分类器指导。

最后,团队还训练了三个模型的级联,用于文本到视频的生成任务,包括一个基本的潜在视频扩散模型和两个视频超分辨率扩散模型,以每秒8帧的速度,生成512x896分辨率的视频。

W.A.L.T的出现说明了什么?

在视频生成领域,Runway Gen-2、Zero Scope等应用珠玉在前,一大波“后浪”汹涌而至。

加上W.A.L.T,近期已有多个视频生成应用惊艳亮相,包括爆火出圈的Pika,以及三大图片转视频神器——阿里的Animate Anyone、字节跳动的Magic Animate、微软的GAIA。

Pika的投资人名单几乎集齐了硅谷的半壁江山,其他应用背后均站着科技巨头。

W.A.L.T在内的工具的密集出现,再次说明一个问题:各方势力竞相加码,但相关应用的优化迭代速度和商业化进程均较慢,大公司与初创团队势均力敌,终局之战远未到来,文生视频应用的潜力还没有彻底被开发。

主要原因在于,视频生成应用的底层模型及技术仍在优化,未筛选出最优模型。

在图像和视频生成应用上,当下的主流技术路线为Diffusion Model(扩散模型),但各家采用的模型均有自己的创新点。比如W.A.L.T的窗口注意力机制。Pika联合创始人孟晨琳此前也透露:“Pika也不能完全算Diffusion Model,我们开发了很多新东西,是一种新的模型。”

由于底层技术不同,各产品存在各自的优劣势,比如,基于Transformer的代表Phenaki突破了视频生成时长限制,但效果相对粗糙缺少细节;基于扩散模型的代表Make-AVideo重在提升视频质量,但其视频时长均在4秒以内。

如何找到视频生成时长、效果、成本之间的平衡点?该领域的研究者依然在寻求最优解。

视频生成背后暗藏机器人机遇?

值得注意的是,李飞飞研究领域涉及计算机视觉、机器学习、深度学习、认知神经科学等,而近年来其关注的重点聚焦在AI智能体,即具身智能。负责介绍W.A.L.T的研究人员Agrim Gupta是论文《通过学习和进化实现具身智能》的第一作者。

在李飞飞看来,计算机视觉未来的重点方向就是具身智能,她认为,具身AI可能会给我们带来一次重大的转变,从识别图像等机器学习的简单能力,转变到学习如何通过多个步骤执行复杂的类人任务。

具身智能,可以理解为具备自主决策和行动能力的机器人/仿真人,是通用AI的高级形态。W.A.L.T模型的另一研究方谷歌已经在研究,如何将其原生多模态大模型Gemini与机器人技术结合起来。

作为多模态应用的重要分支,视频生成与机器人的视觉感知力有着密切的关系。基于此,李飞飞团队投身视频生成模型,并没有偏离其具身智能研究。未来如何?我们静观其变。