制作一集像这样的动画,你觉得需要多久?

在传统动漫行业里,动画制作往往是费时最多的一个环节,动画师们要根据分镜脚本和美术设计,制作各个镜头的动画效果。

从设计角色到描绘场景,再制成动画,一个制作团队往往要花上几个月甚至一年的时间。

但在最近,这条行业定律正在被 AI 工具重新改写。

你现在看到的这部动画短片包含了 120 个视觉效果镜头,总时长为 7 分钟,而其制作团队 Corridor 在动画制作上只花了几个小时。

效率的秘密就藏在他们用的工具—— Stable Diffusion 之中。

众所周知,动画里的每一个运动镜头都是由画师们逐帧画出的连续运动图画拼凑而成,每集动画的背后几乎都是由成千上万张画稿堆积而成。

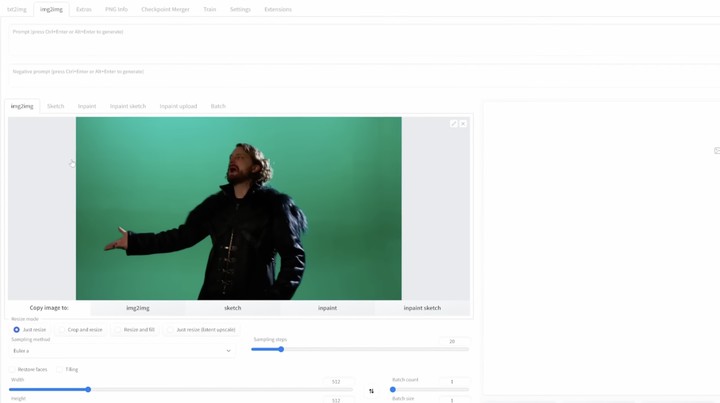

用人手逐帧绘制动画对 Corridor 来说几乎是不可能完成的任务,于是他们想到了另一种制画思路:摄像机拍摄画面本质上也是一帧帧的照片,如果将其逐帧转化为动画风格再拼接在一起,不就是动画了吗?

要批量地把照片转化成动漫图画,Corridor 首先想到的是目前最为流行的 AI 绘图工具:Stable Diffusion。

与 Dall-E 2、Midjourney 等 AI 绘图工具相比,Stable Diffusion 的一大优势在于它是开源项目,用户可以在本地配制出最合适的数据库,让 AI 定向学习画画风格,然后就能批量生出该风格的图片。

根据提前构想的设定,Corridor 让 Stable Diffusion 学习了大量《吸血鬼日记》的图片,以及两位主演的各个角度照片,使得让转化出来的动画图片尽可能准确,并且风格趋于统一。

待 Stable Diffusion 将整段影片转化成动画风格后,剔除掉一些不稳定的画面,再加上消除闪烁处理,最后用虚拟相机拍摄的背景替换上绿幕,原本需要十几个画师画几个星期的动画就制作完成。

看到这,你是不是也想发挥一下想象力,自己动手拍摄一条动画短片、或者把自己 P 成各种幻想英雄的模样?

虽然 Stable Diffusion 有着高可控性等优点,但要想驾驭它,首先你需要在服务器端或本地端一个强大的计算环境供它运行。

换句话说,如果你空有想象力,而没有强大的自然语言学习和处理能力,以及 AI 算力作为支持,照样不能用 Stable Diffusion 创作。

那么,有没有一种方式,能让普通人也能轻松自己画出一个独一无二的头像呢?

还真有,而且只要「有手机就行」。

在 MWC 大会上,高通首次演示了在 Android 手机上本地运行的 Stable Diffusion,还展示了多张在手机端侧生成的 AI 图片,效果看起来还挺不错,且整个过程只需要不到 15 秒。

Stable Diffusion 的参数超过 10 亿,普通的电脑跑起来都很吃力,高通是怎么把如此庞大的模型「塞」进手机里,并让它在手机的 SoC 上也能顺利运行呢?

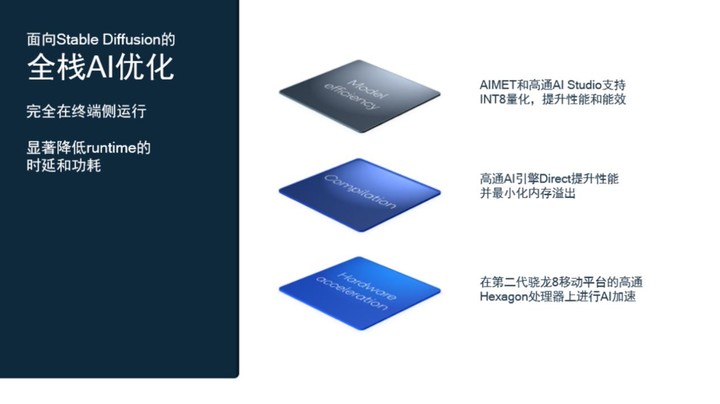

为了「把大象放进冰箱」,高通的工程师首先对大象进行优化。

在这里,首先要提一下第二代骁龙 8 移动平台在 AI 方面的一项重大提升,自然语言处理(NLP)。

自然语言处理是 AI 应用的全新领域之一,为了尽可能快速地理解和分解人类语言,高通显著提升了 Hexagon 处理器并增加硬件加速,能够更加快速高效地运行 Transformer 网络,并通过微切片推理降低功耗,使第二代骁龙 8 在自然语言处理用例上显示出独特的优势。

为了能够让 Stable Diffusion 实现在终端侧运行,高通工程师们选择从 Hugging Face 的 FP32 1-5 版本开源模型入手,使用高通 AI 模型增效工具包(AIMET)对其进行训练后量化,在不牺牲模型精度的情况下,把原本的 FP32 模型压缩为计算效率更高的 INT8 格式。

通过高通所推出的统一 AI 软件解决方案高通 AI 软件栈,高通能够在不损失模型精度的情况下量化精简 AI 模型,大幅提高 AI 推理性能,还能降低功耗,使大型 AI 模型能够更加适应手机等终端侧低功耗计算环境,让 AI 模型的终端侧扩展变得更加简单。

通过软件和硬件全栈优化,Stable Diffusion 最终得以在集成了 Hexagon 处理器的第二代骁龙 8 移动平台上运行,在 15 秒内执行 20 步推理,生成一张 512×512 像素的图像,这样的速度已经足以和云端计算的时延相媲美。

也就是说,云端大型生成式 AI 模型已经迈出了终端侧应用扩展的第一步。

虽然你还不能像 Corridor 那样用 Stable Diffusion 拍大片,但是用它来给自己画头像、拍虚拟写真已经绰绰有余。无论你想要莫奈、梵高还是鸟山明画风的自画像,直接在手机上输入指令,就能一键生成独一无二的 AI 作品。

未来,或许还将有数百亿参数规模的 AI 模型能够得以在终端侧运行,你手机上的 AI 助手智能水平将会有质的飞跃。生成式 AI 模型终端侧部署所带来的可能性超乎想象。

提起 AI 计算,很多人第一时间想到的可能是大型云端服务器,AI 似乎离我们的生活很远。

但实际上,你每一次解锁手机、唤醒语音助手、甚至随手按下快门,都是一次与 AI 计算的亲密接触。

由于在包括手机在内的终端侧进行 AI 处理在可靠性、延时、隐私等方面有着诸多优势,越来越多的 AI 云端大模型开始转向终端侧上运行。

如今,AI 计算已经伴随终端部署渗透进了我们生活的方方面面,在智能手机、平板电脑、XR 眼镜甚至汽车等终端产品上你都能轻易地找到 AI 的身影。这是高通一直在打造的智能网联边缘愿景,为此高通已经默默努力了十余年。

将 AI 从云带到终端,可以一次性解决用户两个痛点需求:一方面,终端处理的数据可以保留在终端设备上,用户个人数据隐私得到妥善保护。另一方面,终端设备可以及时进行计算处理,为用户提供低延时、可靠的处理结果。

高通此次在 Android 手机上率先部署 Stable Diffusion,不仅给用户提供了随时随地进行 AI 创作的可能性,也让未来的图像编辑充满了想象力。

Stable Diffusion 模型编码了大量语言和视觉知识,通过对模型进行调整,可以为图像编辑、图像修复、风格转换和超分辨率等方面带来切实的影响。

试想一下,未来你可以脱离互联网拍摄出迪斯尼风格、日漫风格的照片或影片,并且一切的图像计算都仅在手机中进行,既有趣好玩又能守护隐私安全。

而在高通的技术规划里,这还只是一个开始。

此前,高通发布了一个名为「高通 AI 软件栈」的解决方案,简单来说就是只需要开发一次模型,就能在所有不同的终端上进行扩展。

高通在 Stable Diffusion 上取得的研究突破和技术优化未来都会融入到高通 AI 软件栈中,以后只需要在此基础上对它进行扩展,就能打造出适合 XR 眼镜、汽车等平台的不同模型,这也被高通称之为「统一的技术路线图」。

通过这样的产品开发路线,高通可以把智能手机终端上领先的自然语言处理、面部识别等 AI 技术集成到 XR 眼镜、PC、物联网、汽车等产品之中,最终为用户创造新的智能体验。

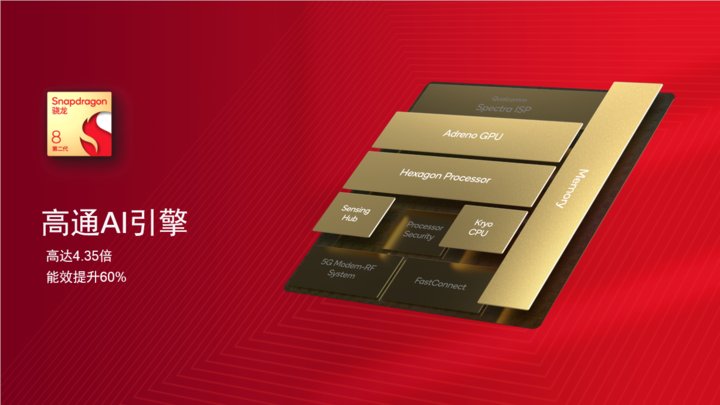

如此高灵活性、高效率的开发模式与高通 AI 引擎密不可分。

高通 AI 引擎包含图形处理单元、CPU、以及最为关键的 Hexagon 处理器。

其中 Hexagon 处理器由标量、向量和张量处理器组成,三个加速器使用统一的共享内存,高通将张量加速器的计算性能提升了一倍,同时共享内存的容量也提升了一倍,使得新一代高通 AI 引擎相比前代在能效比上提升了 70%。

高通 AI 引擎可以灵活地进行硬件拓展,在移动平台上通常会配置一个 Hexagon 处理器使用;在面向汽车、云和边缘计算平台时,则可以使用多个 Hexagon 处理器实例来提高算力。

结合领先对手的架构优势和算力表现,高通可以说用高通 AI 引擎构成了打通智能手机、物联网、XR 眼镜、汽车等业务的核心。

根据高通的设想,AI 计算接下来会继续朝着完全的分布式的方向继续发展,即 AI 推理会从云端大量转移到终端侧。

例如手机会学习用户的口音,提高语音的准确率;汽车会学习不同的路况,提高对障碍的识别率等,这些都是 AI 在终端普及的应用案例。

去年 12 月,高通携手新晋奥斯卡影后杨紫琼描绘了这样一副万物智能互联的未来景象:

在高通 AI 引擎的驱动下,智能手机正在变得更聪明。它掌握了专业影像技巧,让你随手就能拍出 8K 电影级大场面;它还拥有了自然语言处理能力,能像助手一样,主动为你提供实时翻译等定制化服务。

高通 AI 引擎将使汽车进化成可靠的司机。在未来,汽车能感知你的到来,按你的习惯做出自适应调整;强大的算力带来了驾驶辅助、情境安全感知和流媒体娱乐等丰富功能,还可以预见前方路况,改善驾驶体验,让你既舒适又安全的抵达目的地。

而 XR 等可穿戴设备,将为你带来更具沉浸感的体验和更直观的交互,让你尽情游走在虚拟与现实世界。

总得来说,当下的我们身处于万千可能之中,围绕在我们身边的 AI 创新正在重塑世界,悄然改变着我们的工作、生活和沟通方式。

目前,智能手机是 AI 技术最佳应用平台,但 AI 技术在智能手机上的普及只是第一步,未来 AI 技术会变得无处不在,人们的生产力、创作力也将得到更进一步的释放,而高通早已为此做好了准备。