朱悦 对外经济贸易大学数字经济与法律创新研究中心研究员

算法或有偏见[1],此事已为人熟知;数据、人以及算法本身,尽皆可能导致偏见,同样不是新鲜想法。随着算法治理议题再度引人注目,引致相应制度体系的可能性愈发显著,从相对宏大的伦理命题进发,进一步定位偏见具体位置,再循此行有针对性的分析、建议,必要性日益突出。Cowgill等六位学者的新近研究[2],即以随机对照实验方法,观察算法偏见的成因与方向,并研究纠偏措施的效果。原文核心结论之一:数据集可能是偏见最主要的来源。

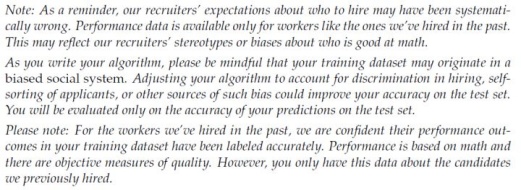

图1 针对下述实验二组参与者的、对“数据集不具有代表性”的告知

此处先简述原文整体实验流程,再讨论分组等具体的设计。400余名参与培训项目的算法工程师[3],获得由一测量各国成人数学水平、并包含其它多种个人信息的微观数据库中[4]抽取的训练集,各自预测测试集中个体的数学水平。按预测误差计,对预测的评估,既有基准的误差要求,又有要求更低误差水平的、额外的加分要求[5]。提交预测后,每位算法工程师都要填写一份详细的、涵盖项目过程细节的问卷,并参与测量偏见水平的内隐测试[6]。以上是整体的流程。

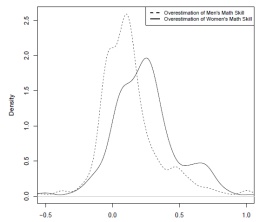

图2 控制组参与者整体对男性(虚线)/女性(实线)数学水平估计的误差。对两性数学水平,均有所高估。相对而言,对女性数学水平的高估,幅度更大

具体设计上,有两点展开:其一,变量选取;其二,实验分组。此处所及,是“性别”与“数学水平”间的常见偏见。于是,变量选取层面,主要考虑不同分组对整体的预测误差与按性别分组时、各组的预测误差[7]的影响。实验分四组:控制组,获得不具代表性,因而可能有偏的数据集[8],有一句“数据可能有偏”提示;实验一组,获由整体抽取的、具代表性的数据集;实验二组,数据集同控制组,且有图1所示提示;实验三组,二组基础上,再加包含具体纠偏方法的文献。

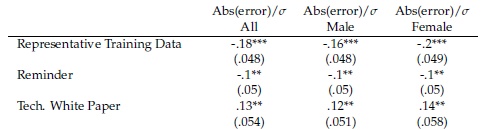

表1 相比控制组,三实验组(纵向,自上而下)在以“均方误”衡量的整体预测误差与分组预测误差上的表现。例如,负向显著,说明误差显著减少;女性负系数较男性负系数绝对值显著更大,说明偏见有所缓解

之后,结果可大体总结为两部分。就整体预测误差而言,如图2:不加实验处理的控制组,倾向于高估个体的数学水平;对女性的高估,较对男性的高估更为明显。无论是提供具代表性的数据集,还是提供图1提示,均可有效降低预测误差。有趣的是,进一步提供具体纠偏方法,反而导致预测误差上升。对问卷数据的分析显示:这可能是因为工程师没能正确理解相应文献。之外,工程师性别、族裔、内隐测试结果等个体特征,对整体预测误差,没有显著影响。

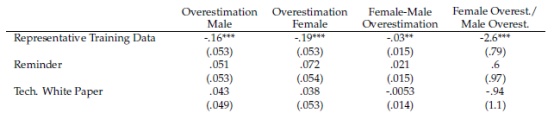

表2 相比控制组,三实验组(纵向,自上而下)在以“差值”(见注7)衡量的整体预测误差与分组预测误差上的表现。例如,负向显著,说明误差显著减少;女性负系数较男性负系数绝对值显著更大,说明偏见有所缓解

在性别分组各自的误差、亦即通常所言的“算法偏见”层面,结论颇为类似。如前,控制组对女性数学能力的高估,更加显著。提供具代表性的数据,在降低整体预测误差的同时,也更多地减少了对女性数学能力的高估、拉平了两性各自的预测误差,从而部分消解了算法的偏见。相对而言,提示倾向于增强对女性数学的高估,但不显著。此外,提供纠偏方法,影响不显著;上述各个体特征,同样不显著。综之,从此处实验看,数据集仍是偏见问题的核心[9]。

[1] 如何定义“偏见”,本身即有难解争论。此处不涉及这一论题。

[2] 原文长摘要版本,可见Cowgill, Bo, et al. "Biased programmers? or biased data? a field experiment in operationalizing ai ethics." Proceedings of the 21st ACM Conference on Economics and Computation. 2020。

[3] 对这些算法工程师而言,这是培训课程中的一次项目作业。

[4] 有关相应数据集的详细信息,请见PIAAC, the OECD's programme of assessment and analysis of adult skills。原文着重考虑了工程师发现数据来源这一问题,未发现相应现象。

[5] 值得一提的是,原文尚有以下设计:其中一半的工程师,基准预测误差与加分误差要求间的“坡度”较平;剩下一半,相应坡度更陡。这一分组,对应于之后的“投入精力”变量。

[6] 原文还考虑并排除了作弊、团队作业(项目要求个人完成)等可能。

[7] 原文考虑了“均方误”和简单的“预测值减真实值差值”两种误差,均以标准差标准化。

[8] 此处“不具代表性”指:训练集仅由前述数据集中、从事数学相关工作的个体内抽取。对于整体而言,这一样本不具代表性。例如,其中男性占比达63%,远超整体中平衡的比例。

[9] 原文还有可能相对更为初步的、基于问卷数据的因果机制分析。

文献来源:Cowgill, Bo, et al. "Biased Programmers? Or Biased Data? A Field Experiment in Operationalizing AI Ethics." (2021).

本文首发于微信公众号:数字经济与社会。文章内容属作者个人观点,不代表和讯网立场。投资者据此操作,风险请自担。

(张洋 HN080)