Hi

财经作家吴晓波曾经给过去十年一个概括,用的就是“水大鱼大”,所谓“没有企业的时代”,只有“时代的企业”,正因为中国这汪大湖过去十年大水猛涨,中国公司的体量随之膨胀。而“水大鱼大”的比喻,在人工智能产业的发展来说,又极其的贴切。

人工智能的每一步发展都是因为这个时代的环境使然。得益于数据量的爆炸式增长、计算能力的大幅提升、机器学习算法的持续优化,人工智能产业正快速发展。IDC预测:在2025年,全球数据量将达到史无前例的163ZB;同时,5G和AI结合带动了全球算力爆炸式增长,从2016年开始到现在AI算力增长了约30万倍。就算法来看,大模型成了AI产学界刷屏率颇高的词汇,更大算力、更大数据集的大模型,或许才是未来AI最好的伙伴。

在这样一个人工智能的汪洋大海里,无论是AI芯片、AI服务器等领域,都已经涌现出了一批巨头。

AI算法模型,更巨量者得天下?

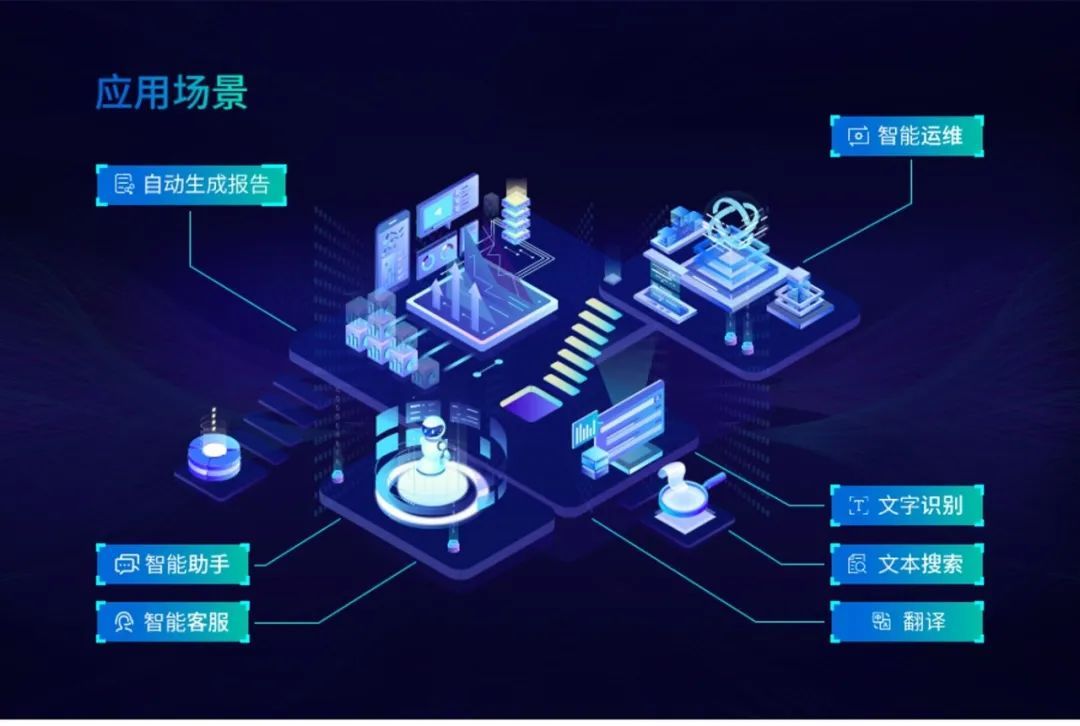

人工智能已经从五六年前的 “黑科技”变成了今天的“热科技”,并与各个产业深度融合,加速推动着智慧时代的到来。但同时,人工智能的落地应用从“可用”走向“好用”,还存在着诸多挑战。

就算法来说,深度学习技术兴起的近10年间,AI模型基本上是针对特定应用场景需求进行训练的小模型。而在中国工程院院士、浪潮首席科学家王恩东看来,人工智能如何发展出像人类具备逻辑、意识和推理的认知能力,是人工智能研究一直在探索的方向。“目前来看,通过大规模数据训练超大参数量的巨量模型,被认为是非常有希望实现通用人工智能的一个重要方向。”王恩东院士认为,随着巨量模型的兴起,巨量化已成为未来人工智能发展非常重要的一个趋势。

算法模型为什么要从“小”到“大”?浪潮信息(000977,股吧)人工智能研究院首席研究员吴韶华作了进一步解释,小模型用特定领域有标注的数据训练,通用性差,换到另外一个应用场景中往往不适用,这样有一个很糟糕的结果就是,针对于任何一个任务都要微调出来一个有针对性的模型。极端的真实案例里,就有一家客户产生了几百种模型来支撑几百种产品。另外,小模型的训练方式需要大规模的标注数据,如果某些应用场景的数据量少,训练出的模型精度就会不理想。而大模型技术路线可有效解决这个问题。“大模型有非常突出的小样本学习,甚至零样本学习的能力,很有希望去解决这种不同场景下模型繁多的问题,一个模型训练出来可以适用于不同的场景。“

“巨量数据、巨量算法和巨量算力”正成为迈向通用人工智能的重要路径,OpenAI、微软、谷歌、英伟达、浪潮信息等科技巨头纷纷发力“大模型”创新。更有研究预计,大模型将在三到五年的时间里开始真正深刻影响产业的变革和智能化升级的方向。

在“AICC 2021人工智能计算大会”期间,全球最大规模中文人工智能巨量模型“源1.0”首次亮相。“源1.0”的单体模型参数量达2457亿,训练采用的中文数据集达5000GB,问鼎全球最大规模中文AI巨量模型。这也代表了国内AI巨量模型的一个新高度。但从参数量的角度来看,“源1.0”还远没有到尽头,按照目前这种趋势,AI产业的玩家们对于更大体量模型的探索仍然会继续下去。

不止于大,从专用智能到通用智能

最近,斯坦福大学数十位研究者联名发表《基础模型的机遇和风险》综述文章,认为大模型的特点之一是“同质化”,好处在于大模型的任何一点改进就可以迅速覆盖整个AI社区,但同时,它也带来一些隐患,大模型的缺陷会被所有下游模型所继承。特点之二是海量数据(603138,股吧)训练出的基础模型具有“涌现”特性,也就是产生未曾预先设想的新能力,这种特性有望让AI具备处理语言、视觉、机器人、推理、人际互动等各类相关任务的能力。

这带来的问题就是,在追求“巨量”的同时,如何规避风险,并通过模型激活各行各业,让AI落地应用?

在浪潮信息副总裁、浪潮信息AI&HPC产品线总经理刘军看来,任何技术的发展总有一个从兴起到成熟再到落地的一个阶段,大模型现在正处于兴起的阶段,大家正在围绕着模型的体量以及模型体量带来的精度效应来开展持续的探索,当大模型探索走向成熟之后,一定要考虑应用的具体问题,比如响应化、高性能推理部署等诸如此类的问题。

同时,刘军认为,AI巨量模型到底要做什么,不做什么,不能天马行空。“可以从两个不同的层面去考虑,一是产业发展的层面,产品怎么去满足客户、满足市场、满足应用需要的发展。二是科研创新,科学的探索方向,去思考怎么样和产业的方向去匹配。“

从“量”上看,“源1.0”相比GPT-3模型1750亿参数量和570GB训练数据集,“源1.0”参数规模领先40%,训练数据集规模领先近10倍。同时“质”上也达到了全球领先,“源1.0”在语言智能方面表现优异,获得中文语言理解评测基准CLUE榜单的零样本学习和小样本学习两类总榜冠军,测试结果显示,人群能够准确分辨人与“源1.0”作品差别的成功率已低于50%。

但单纯的追求“大”并不是浪潮信息的目标。刘军表示:“巨量模型不是大公司专享,应该成为普惠性的科技进步力量,让行业用户甚至是中小用户也能使用巨量模型寻求深度创新,促进业务可持续健康发展”。吴韶华对此也表示,巨量模型的发展并不是真的在比大,大不是目的,最根本的目的,从技术层面来讲就是要追求通用智能,就是从专用智能走向通用智能。

开源开放,从“顺势而为”到“扶摇直上”

在AICC 2021大会上,浪潮信息推出“源1.0”开放开源计划,“源1.0”将面向学术研究单位和产业实践用户进行开源、开放、共享。

其实,将AI算法模型进行开源已经是AI产业的通用做法,但回到浪潮信息自身来看,这一步棋还是有不一样的涵义。

首先,浪潮信息“源1.0”作为全球最大规模的中文AI巨量模型,除了规模大、数据大、性能强之外,无论是开放模型API,开放高质量中文数据集,开源模型训练代码、推理代码和应用代码等都需要浪潮信息有强有力的支撑,能够做好支撑行业AI开发者的坚实底座。

先看浪潮信息“源1.0”的开源底气何来?《逍遥游》中说,“水之积也不厚,则其负大舟也无力”“风之积也不厚,则其负大翼也无力”,全球最大的中文AI巨量模型诞生,得益于浪潮信息在人工智能领域深厚的积累和不断的探索实践。浪潮信息一直活跃在AI前沿方向,在异构加速计算、深度学习框架、AI算法等领域取得了一定的成绩。

目前,浪潮信息的AI服务器市占率已位居全球第一,连续4年中国市场占比超过50%;在深度学习框架领域,浪潮信息先后推出了深度学习并行计算框架Caffe-MPI、TensorFlow-Opt、全球首个FPGA高效AI计算开源框架TF2等等。2020年,浪潮信息在人工智能领域的专利贡献达到1174件,位居中国前列。

其次,在国内已经有许多厂商开放AI算法模型的前提下,浪潮信息开放“源1.0”,必然需要走差异化的道路,提供给AI开发者和产业不一样的价值,如此其开源才有意义。

浪潮信息作为智算中心的提出者,可以让智算中心这一算力基础设施和巨量模型这一算法基础设施行成协同效应。因为大模型的训练运行需要智算中心的基础设施,需要算力基础设施来作为算力平台,两者的协同工作,能为产业AI提供一个强大的推动力。

正是因为国内人工智能产业的迅猛壮大,才能产生浪潮信息AI服务器市占率位居全球第一、“源1.0”成为全球最大的中文AI巨量模型这样的成绩,“水大鱼大”,浪潮信息不止做到了顺势而为,还做到了“扶摇直上”, 负产业之志,然后图南,浪潮信息“源1.0”有“绝云气,负青天”之志,更是中国AI产业扶摇而上者九万里的希望所在。

Hi

本文首发于微信公众号:略懂的小咖。文章内容属作者个人观点,不代表和讯网立场。投资者据此操作,风险请自担。

(李佳佳 HN153)